LLMも「脳腐敗」、低品質データで性能低下か

詳細を読む

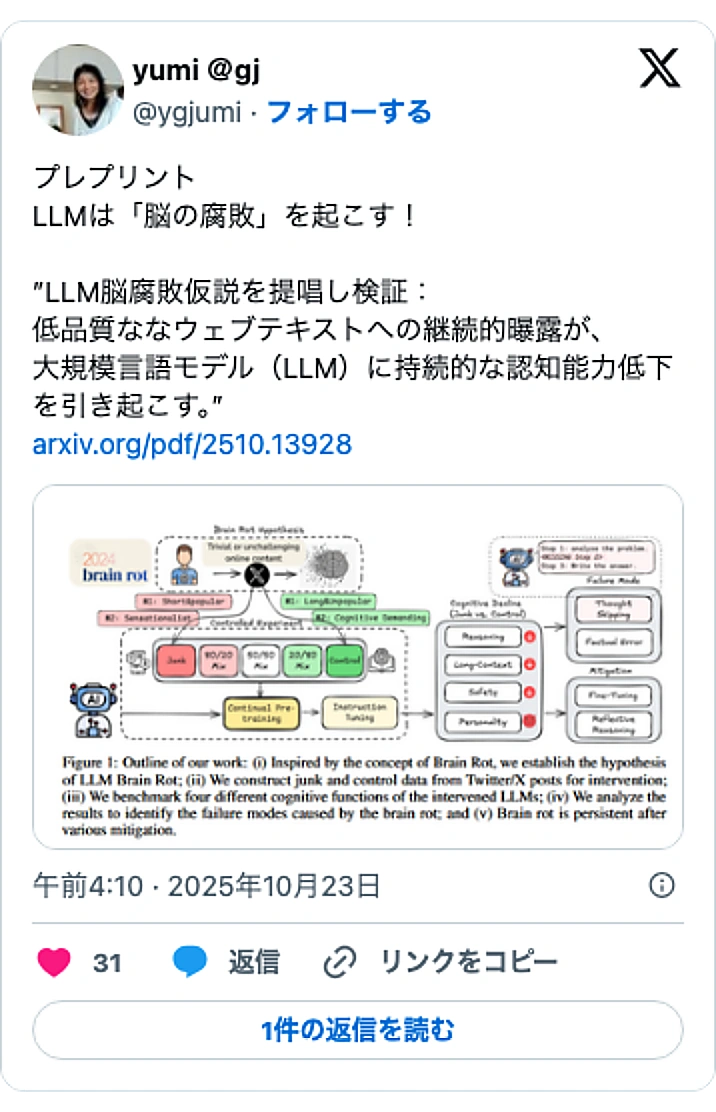

テキサスA&M;大学など米国の研究チームが、大規模言語モデル(LLM)を低品質な「ジャンクデータ」で継続的に学習させると、人間の「脳腐敗」に似た性能低下が起きる可能性を指摘する論文を発表しました。この研究は、LLMの性能を維持・向上させる上で、学習に用いるデータの「量」だけでなく「質」が極めて重要であることを示唆しており、AIをビジネス活用する企業にとって重要な知見となりそうです。

研究チームが提唱するのは「LLM脳腐敗仮説」です。これは、人間がインターネット上で些細で質の低いコンテンツを大量に消費すると、注意⼒や記憶⼒が低下する現象に着想を得ています。同様に、LLMもジャンクなウェブテキストで事前学習を続けると、持続的な認知能力の低下を招くのではないか、というのが仮説の骨子です。

では、何が「ジャンクデータ」と見なされるのでしょうか。研究チームはHuggingFaceが公開する1億件のツイートデータを分析し、2つの指標で定義を試みました。一つは、エンゲージメント(いいね、リツイート等)は高いが、文章が短いツイートです。これらは些細な内容でユーザーの注意を引く「ジャンク」の典型例とされました。

もう一つの指標は、ツイートの「意味的な質」です。研究チームはGPT-4oを活用し、陰謀論、誇張された主張、根拠のない断言、あるいはクリックベイトのような扇動的な見出しを含むツイートを「ジャンク」として分類しました。このAIによる分類の精度を人間が検証したところ、76%の一致率を示し、一定の信頼性が確認されています。

この研究は、AIをビジネスに活用する経営者やエンジニアに重要な問いを投げかけています。自社データなどでLLMをファインチューニングする際、安易に大量のデータを投入するだけでは、かえってモデルの性能を損なう危険性があるのです。AI戦略において、データの品質をいかに担保するかというデータガバナンスの重要性が、改めて浮き彫りになったと言えるでしょう。